reference

wolframalpha-as-the-way-to-bring-computational-knowledge-superpowers-to-chatgpt

chatgpt-gets-its-wolfram-superpowers

what-is-chatgpt-doing-and-why-does-it-work

Next-Generation Human-Robot Interaction with ChatGPT and ROS

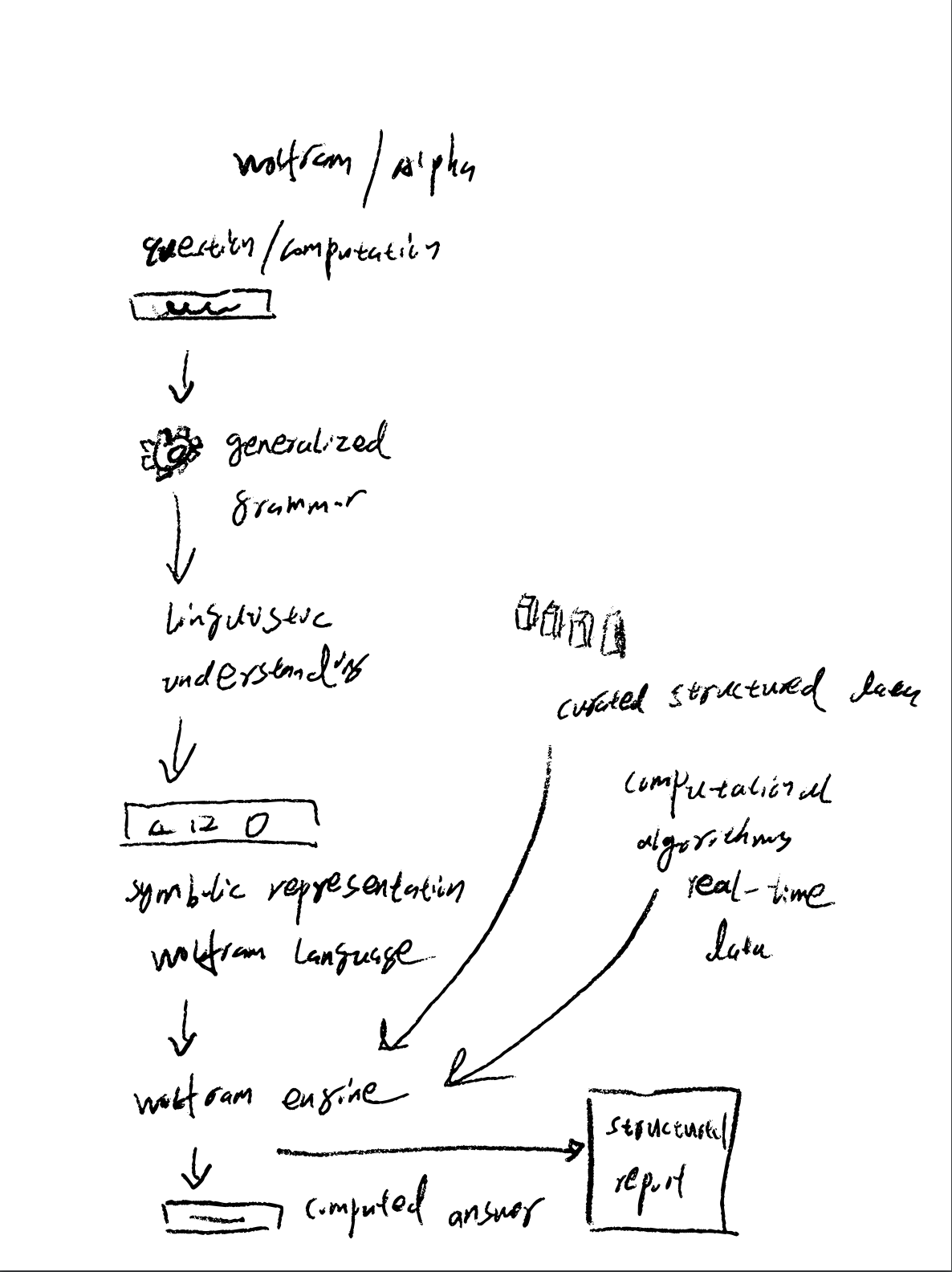

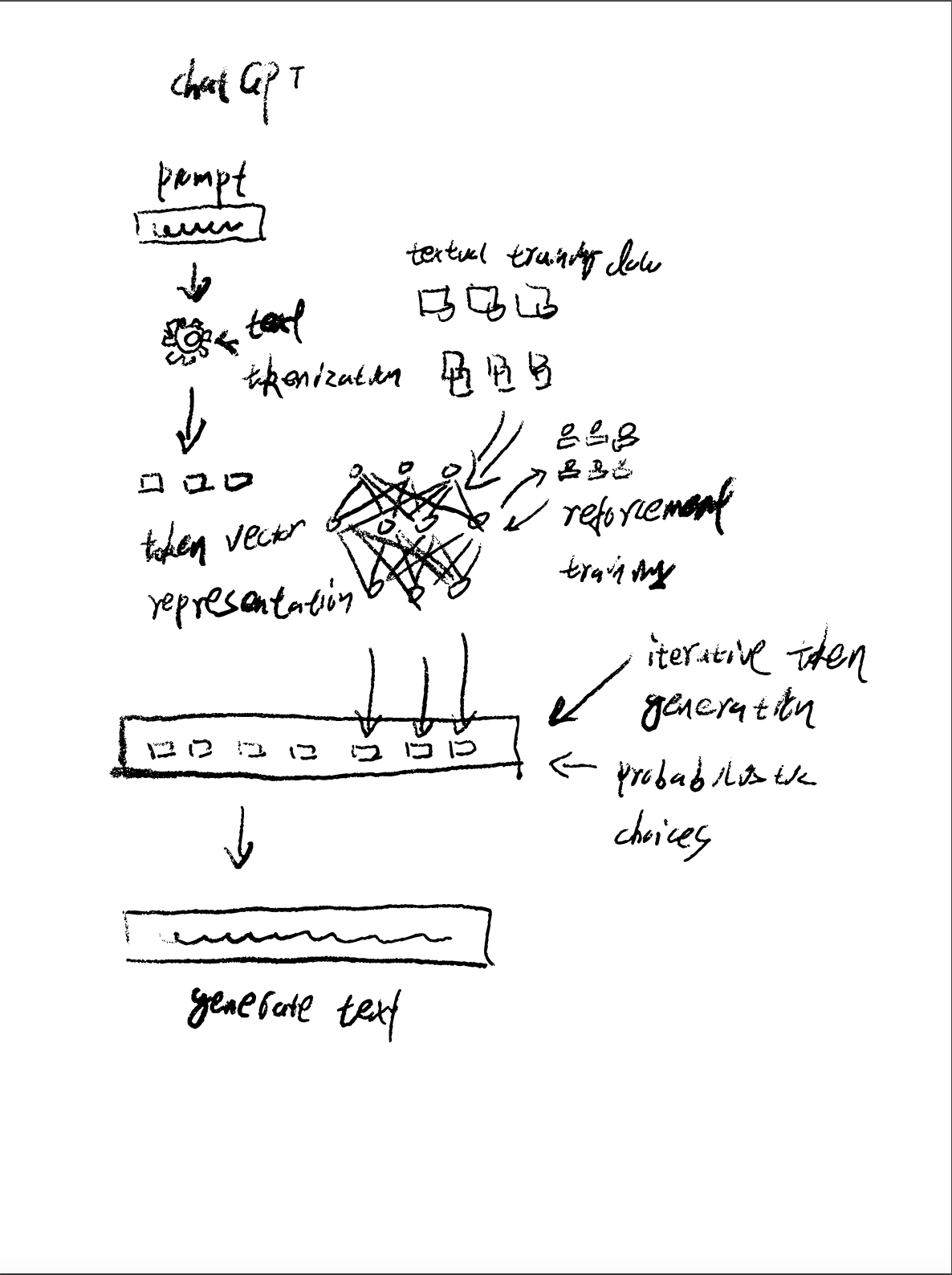

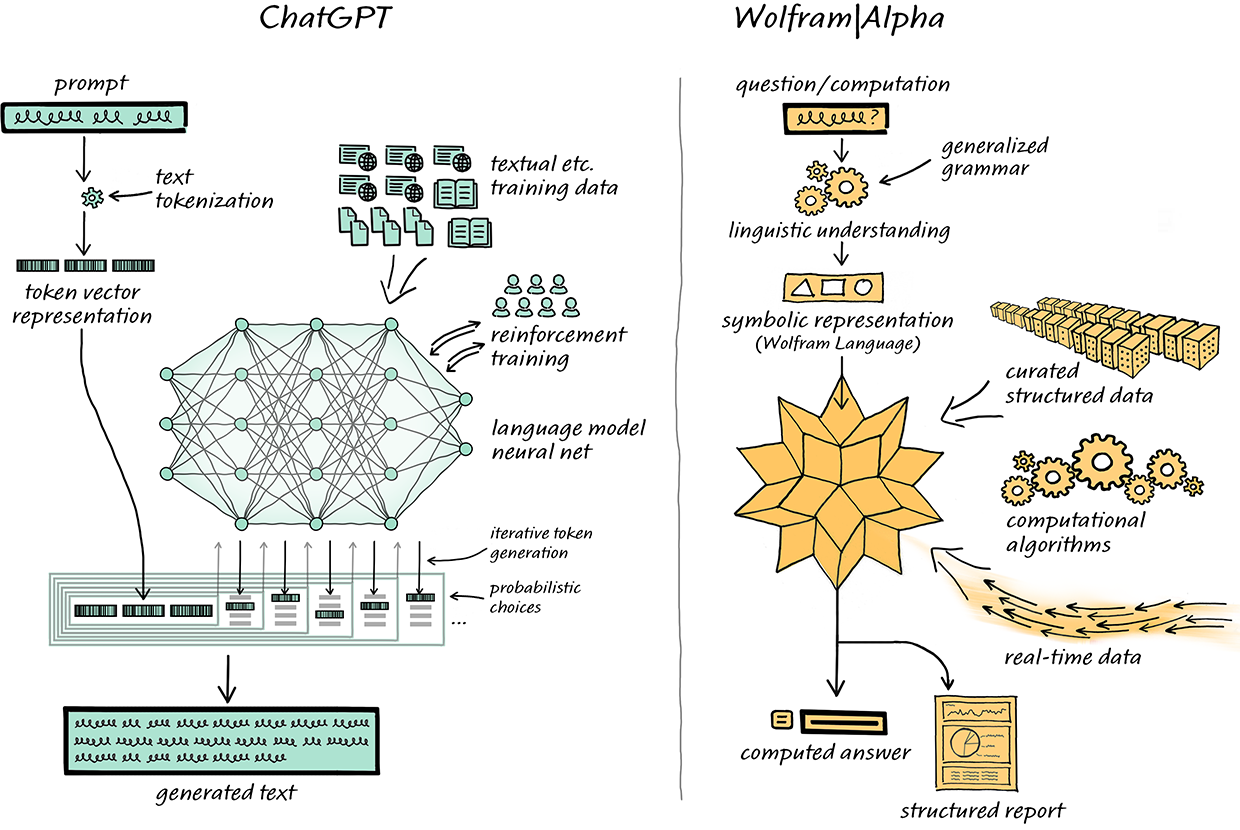

原理构建

最近火热的chatgpt,将生成式人工智能推进到了一个新的高度,但是目前看到大部分的人都将其应用于聊天工具,甚至还有人用它当维基百科使用,但是我觉得既然是生成式的,为什么不用做人与机器人之间的交互,我们使用特定的自然语言描述需要让机器人做的操作,chatgpt通过理解我们的自然语言,将其翻译成类似程序源码的结构化语言,然后输入到机器人的系统中,机器人操作系统会按照输入的结构化语言去完成对应的操作。所以我就在思考如何将RoboMaster EP结合LLM语言类模型来完成人类与机器人之间的交互。像chatgpt这样的API应用有一个弊端,因为它的模型是运行在云端的,并且对某些国家以及地区有限制,所以要做成商业化的工业LLM应用基本上可以排除掉,我希望模型能够运行在本地,并且能够自己去训练优化模型,这个时候Databricks发布了Dolly v2.0模型,数据集以及训练模型全部开放源码,可以应用于商业领域,看了相关介绍之后我决定使用dolly v2.0做为本地LLM模型的首选。

以上的整套系统都是基于ROS2(Robot Operating System)构建,Dolly以及Whisper模型都会运行在本地服务器上,这样我们就可以在本地快速的搭建和实现Robot with GPT原型。

Kubernetes + ROS2 + GPT + Whisper

设想我们在云端有一套kubernetes基础设施,现在我们要在远程的机器人上运行像chatGPT一样的模型,问题的关键在于机器人本身的硬件设备是没有能力运行chatGPT这样的模型的,解决方案就是将模型运行在云端,机器人通过高速互联网络去使用chatGPT,在云端我们通过kubernetes来分配和调度模型运行的资源环境,比如给模型分配TPU或者GPU资源用于推理,而连接机器人和云端的操作系统就是ROS2.0,这样我们就可以控制数以万计的机器人来完成任务,并且他们能很好的理解和帮助人类。